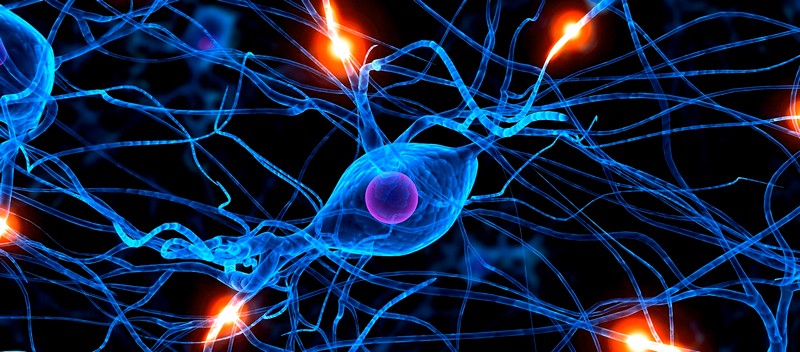

Обучение нейронных сетей является одним из основных этапов в разработке и применении искусственного интеллекта. Нейронные сети используются в различных областях, таких как компьютерное зрение, обработка естественного языка, медицинская диагностика, рекомендательные системы и др. Однако обучение нейронных сетей может быть длительным и ресурсоемким процессом. Для ускорения этого процесса и улучшения качества обученных моделей применяются различные методы оптимизации.

В этой статье мы рассмотрим различные методы оптимизации обучения нейронных сетей, включая градиентный спуск, стохастический градиентный спуск, методы оптимизации с использованием адаптивного шага обучения и другие методы.

Градиентный спуск

Градиентный спуск является одним из основных методов оптимизации обучения нейронных сетей. Он заключается в нахождении минимума функции потерь (ошибки) путем последовательного изменения параметров модели в направлении, противоположном градиенту функции потерь. Градиентный спуск позволяет найти локальный минимум функции потерь, что позволяет улучшить качество модели.

Однако классический градиентный спуск может иметь низкую скорость сходимости и затратный по времени расчет градиента для больших объемов данных. Для решения этих проблем были разработаны различные модификации градиентного спуска.

Стохастический градиентный спуск

Стохастический градиентный спуск является модификацией классического градиентного спуска, который позволяет ускорить обучение нейронных сетей за счет случайной подвыборки данных. Вместо вычисления градиента по всему набору данных, стохастический градиентный спуск вычисляет градиент по случайно выбранной подвыборке данных.

Это позволяет уменьшить вычислительную сложность и ускорить сходимость алгоритма обучения. Однако стохастический градиентный спуск может быть менее стабильным, чем классический градиентный спуск, так как шаг обновления параметров вычисляется на основе случайной подвыборки данных.

Методы оптимизации с использованием адаптивного шага обучения

Для улучшения сходимости градиентного спуска были разработаны методы оптимизации, которые используют адаптивный шаг обучения. Такие методы позволяют изменять скорость обучения для различных параметров модели на основе их градиента.

Примерами таких методов являются Adam, RMSprop, Adagrad и другие. Эти методы позволяют улучшить стабильность и скорость сходимости обучения нейронных сетей.

Методы оптимизации с использованием момента

Другими методами оптимизации обучения нейронных сетей являются методы, использующие понятие момента. Методы оптимизации с использованием момента позволяют ускорить обучение за счет учета предыдущих шагов обновления параметров.

Примером такого метода является метод оптимизации с моментом (Momentum). Этот метод позволяет накапливать импульс обновления параметров и ускорить обучение нейронной сети. Также существуют другие методы оптимизации, использующие понятие момента, такие как Nesterov Accelerated Gradient (NAG) и другие.

Оптимизация обучения с помощью регуляризации

Важным аспектом оптимизации обучения нейронных сетей является регуляризация. Регуляризация позволяет улучшить обобщающую способность модели за счет добавления штрафа за сложность или величину параметров модели.

Одним из методов регуляризации является L1-регуляризация, которая добавляет штраф к функции потерь на основе суммы абсолютных значений параметров модели. Другим методом регуляризации является L2-регуляризация, которая добавляет штраф на основе квадрата значений параметров модели. Регуляризация позволяет уменьшить переобучение модели и улучшить ее обобщающую способность.

Оптимизация с использованием ансамблей моделей

Для улучшения качества обучения нейронных сетей могут применяться методы оптимизации с использованием ансамблей моделей. Ансамбли моделей позволяют объединить несколько моделей для получения улучшенного качества предсказаний.

Примером такого метода является бэггинг, который состоит в обучении нескольких независимых моделей на различных подвыборках данных и объединении их предсказаний. Также существуют методы оптимизации с использованием ансамблей моделей, основанные на голосовании, стекинге и других подходах.

В данной статье мы рассмотрели различные методы оптимизации обучения нейронных сетей, включая градиентный спуск, стохастический градиентный спуск, методы оптимизации с использованием адаптивного шага обучения, методы оптимизации с использованием момента, оптимизацию с помощью регуляризации и оптимизацию с использованием ансамблей моделей.

Каждый из этих методов имеет свои преимущества и недостатки, и может быть эффективен в различных сценариях обучения нейронных сетей. Выбор оптимального метода оптимизации зависит от конкретной задачи, доступных вычислительных ресурсов и других факторов. Однако различные методы оптимизации обучения нейронных сетей позволяют ускорить процесс обучения, улучшить качество моделей и достичь лучших результатов в различных областях применения нейронных сетей.